Loading...

Searching...

No Matches

Include dependency graph for int32_sort.c:

Go to the source code of this file.

Macros | |

| #define | int32 int32_t |

| #define | int32x8_load(z) _mm256_loadu_si256((__m256i *) (z)) |

| #define | int32x8_store(z, i) _mm256_storeu_si256((__m256i *) (z),(i)) |

| #define | int32x8_min _mm256_min_epi32 |

| #define | int32x8_max _mm256_max_epi32 |

| #define | int32x8_MINMAX(a, b) |

Typedefs | |

| typedef __m256i | int32x8 |

Functions | |

| __attribute__ ((noinline)) | |

| void | int32_sort (int32 *x, long long n) |

Macro Definition Documentation

◆ int32

Definition at line 2 of file int32_sort.c.

◆ int32x8_load

| #define int32x8_load | ( | z | ) | _mm256_loadu_si256((__m256i *) (z)) |

Definition at line 8 of file int32_sort.c.

◆ int32x8_max

| #define int32x8_max _mm256_max_epi32 |

Definition at line 11 of file int32_sort.c.

◆ int32x8_min

| #define int32x8_min _mm256_min_epi32 |

Definition at line 10 of file int32_sort.c.

◆ int32x8_MINMAX

Value:

Definition at line 13 of file int32_sort.c.

14 { \

18} while(0)

◆ int32x8_store

| #define int32x8_store | ( | z, | |

| i | |||

| ) | _mm256_storeu_si256((__m256i *) (z),(i)) |

Definition at line 9 of file int32_sort.c.

Typedef Documentation

◆ int32x8

Definition at line 7 of file int32_sort.c.

Function Documentation

◆ __attribute__()

| __attribute__ | ( | (noinline) | ) |

Definition at line 20 of file int32_sort.c.

22{

23 if (n < 8) {

24 while (n > 0) {

25 int32_MINMAX(*x,*y);

26 ++x;

27 ++y;

28 --n;

29 }

30 return;

31 }

32 if (n & 7) {

38 n &= ~7;

39 }

40 do {

46 x += 8;

47 y += 8;

48 n -= 8;

49 } while(n);

50}

References int32_MINMAX, int32x8_load, int32x8_MINMAX, and int32x8_store.

◆ int32_sort()

Definition at line 879 of file int32_sort.c.

881

882 if (n <= 8) {

883 if (n == 8) {

884 int32_MINMAX(x[0],x[1]);

885 int32_MINMAX(x[1],x[2]);

886 int32_MINMAX(x[2],x[3]);

887 int32_MINMAX(x[3],x[4]);

888 int32_MINMAX(x[4],x[5]);

889 int32_MINMAX(x[5],x[6]);

890 int32_MINMAX(x[6],x[7]);

891 }

892 if (n >= 7) {

893 int32_MINMAX(x[0],x[1]);

894 int32_MINMAX(x[1],x[2]);

895 int32_MINMAX(x[2],x[3]);

896 int32_MINMAX(x[3],x[4]);

897 int32_MINMAX(x[4],x[5]);

898 int32_MINMAX(x[5],x[6]);

899 }

900 if (n >= 6) {

901 int32_MINMAX(x[0],x[1]);

902 int32_MINMAX(x[1],x[2]);

903 int32_MINMAX(x[2],x[3]);

904 int32_MINMAX(x[3],x[4]);

905 int32_MINMAX(x[4],x[5]);

906 }

907 if (n >= 5) {

908 int32_MINMAX(x[0],x[1]);

909 int32_MINMAX(x[1],x[2]);

910 int32_MINMAX(x[2],x[3]);

911 int32_MINMAX(x[3],x[4]);

912 }

913 if (n >= 4) {

914 int32_MINMAX(x[0],x[1]);

915 int32_MINMAX(x[1],x[2]);

916 int32_MINMAX(x[2],x[3]);

917 }

918 if (n >= 3) {

919 int32_MINMAX(x[0],x[1]);

920 int32_MINMAX(x[1],x[2]);

921 }

922 if (n >= 2) {

923 int32_MINMAX(x[0],x[1]);

924 }

925 return;

926 }

927

928 if (!(n & (n - 1))) {

929 int32_sort_2power(x,n,0);

930 return;

931 }

932

933 q = 8;

935 /* n > q >= 8 */

936

938 int32x8 y[32];

943 return;

944 }

945

948

950 q >>= 2;

967 }

969 }

978 }

980 }

982 q >>= 1;

983 }

985 j = 0;

1075 }

1078 }

1080 j = 0;

1081 continue16:

1125 }

1128 }

1129 /* q == 8 */

1130 j = 0;

1131 continue8:

1155 }

1170 j += 8;

1171 }

1178 j += 4;

1179 }

1184}

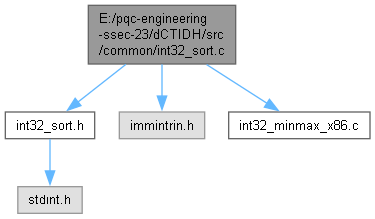

id c6()

References a1, a3, b4, c4, c6(), i, int32, int32_MINMAX, int32_sort, int32x8_load, int32x8_MINMAX, int32x8_store, and j.

Here is the call graph for this function: